خدمات نویان

کراول و اسکرپ (Web Crawling & Data Scraping) — صفحات، APIها و شبکههای اجتماعی

ما دادههای ساختیافته و آمادهی تحلیل را از وبسایتها، فروشگاهها، شبکههای اجتماعی و APIهای عمومی/خصوصی استخراج میکنیم. راهحلها قابل برنامهریزی، مقیاسپذیر و سازگار با نیازهای تحلیلی شما هستند.

آنچه تحویل میدهیم: اسکریپتها یا سرویسهای کراولینگ (یکباره یا زمانبندیشده)

استخراج از صفحات HTML، APIها، فایلها (CSV, Excel, PDF) و شبکههای اجتماعی

پردازش و پاکسازی داده (normalization, deduplication, parsing)

ذخیرهسازی در فرمتهای متداول (CSV, JSON, Parquet) یا ارسال به پایپلاین شما (S3, FTP, DB)

مدیریت پروکسی، چرخش آیپی، و ارسال درخواستهای انسانینما برای عبور از محدودیتها

هندلینگ CAPTCHA و راهکارهای قانونی/اخلاقی (پایبندی به robots.txt و قوانین سایتها)

گزارشگیری و مانیتورینگ کراولها + هشدار خطا

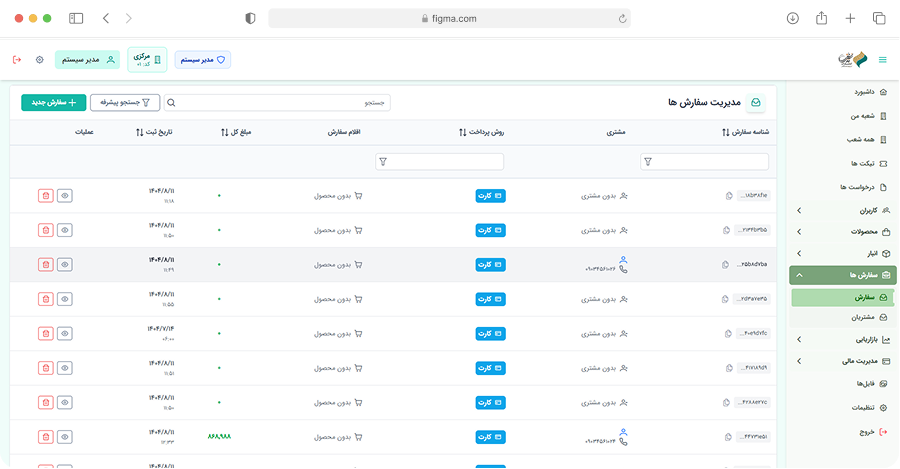

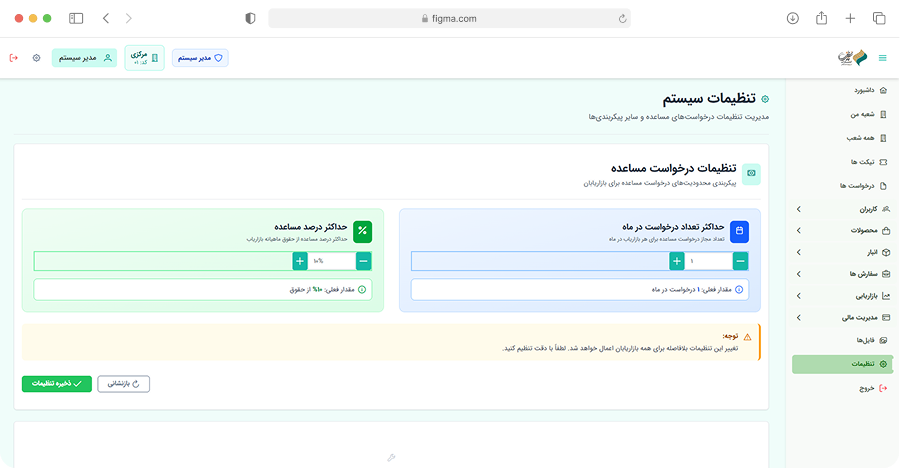

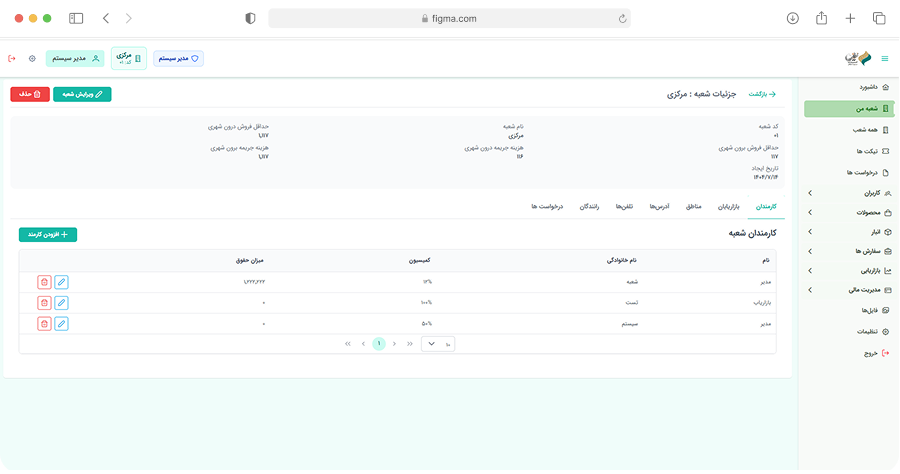

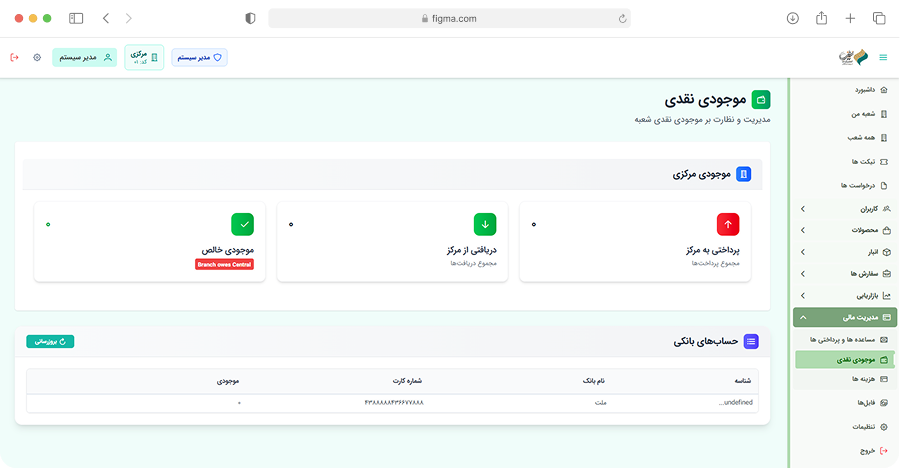

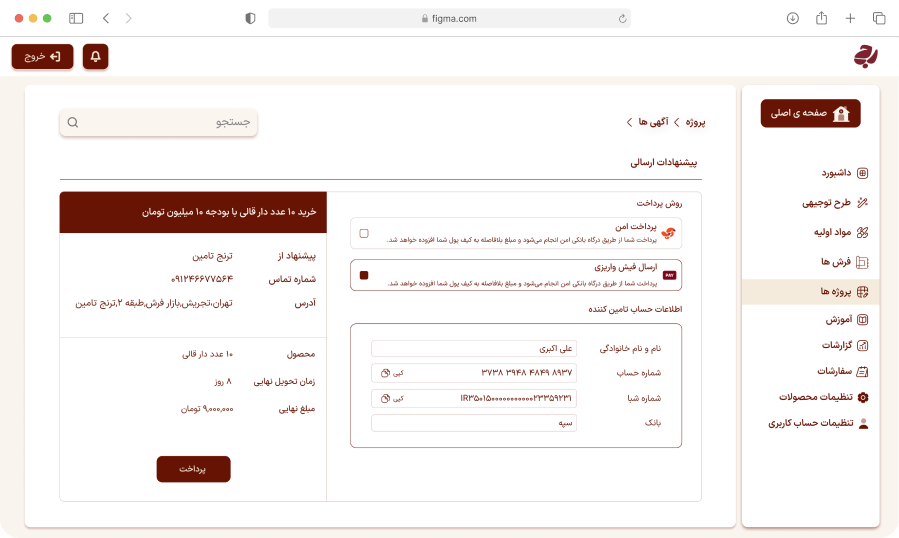

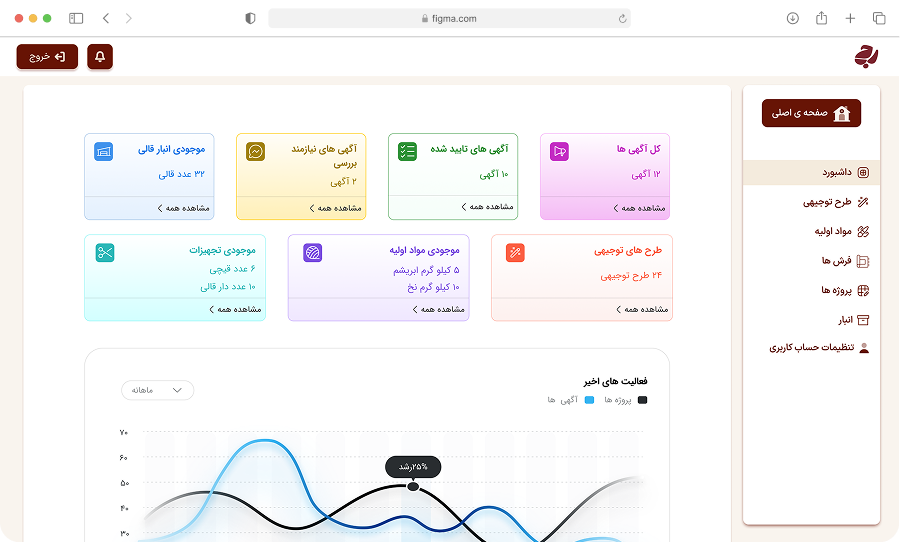

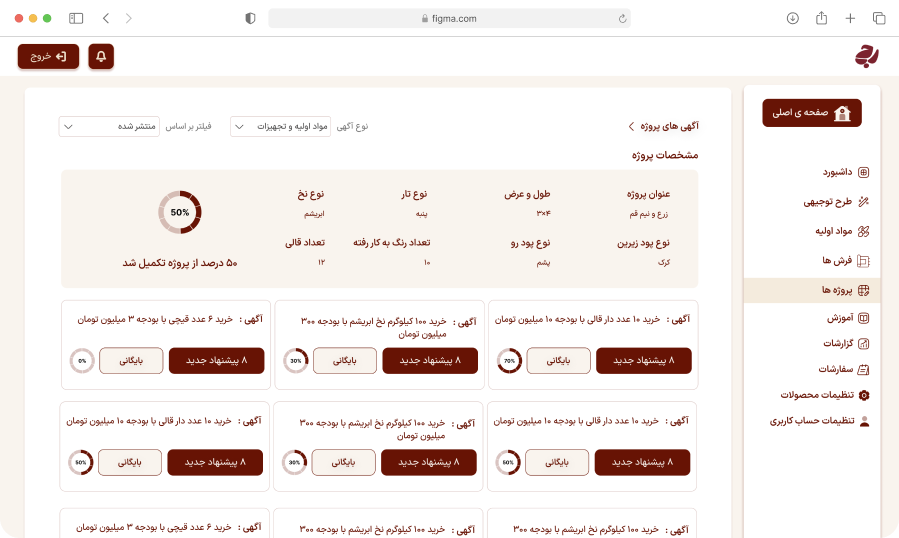

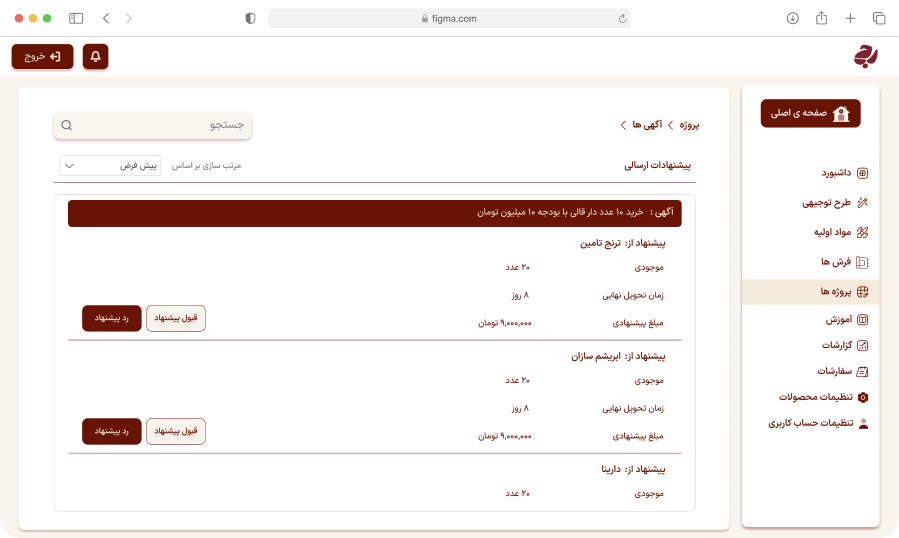

برنامهنویسی اختصاصی پنلهای مدیریتی (ERP / CRM / داشبوردها)

ما در نویان سیستمهای مدیریتی اختصاصی طراحی و توسعه میکنیم که دقیقاً مطابق با فرآیندهای کسبوکار شما باشد — از مدیریت موجودی و حسابداری گرفته تا فروش، تأمینکننده و گزارشدهی تحلیلی. سیستمهای ما امن، قابل توسعه و آمادهی اتصال به سرویسهای خارجی هستند.

آنچه تحویل میدهیم:تحلیل نیازمندی و طراحی معماری سیستم

پنل مدیریت سفارشی با سطوح دسترسی و نقشها (RBAC)

API برای یکپارچهسازی با سایت، درگاه پرداخت، حسابداری و سرویسهای ثالث

طراحی واکنشگرا (Responsive) و تجربه کاربری مناسب برای دسکتاپ/موبایل

مستندات فنی و کاربری + آموزش تیم شما

محیط توسعه، تست و استقرار (Local/Cloud) و استقرار نهایی

قرارداد نگهداری، پشتیبانی و آپدیتهای دورها

اتوماسیون عملکرد، تست خودکار (E2E) و تستهای امنیتی

برای اطمینان از پایداری، کارایی و امنیت سامانهتان، مجموعهی جامعی از خدمات تست و اتوماسیون ارائه میکنیم: تستهای واحد/ادغام/سیستم، تستهای End-to-End خودکار، تستهای بار و فشار، و ارزیابیهای امنیتی از جمله آزمونهای نفوذی برای مشکلاتی مانند brute-force، SQL injection.

اصطلاحات دقیق (که خواسته بودی اسم دقیقشون باشه):

آنچه تحویل میدهیم:

اسکریپتهای تست خودکار E2E برای مسیرهای کلیدی (ثبتنام، خرید، پرداخت، گزارشگیری)

سناریوهای Load/Stress تا حجم مشخص (با نمودار نتایج، نقاط گلوگاه و پیشنهادات)

گزارش کامل ارزیابی آسیبپذیری شامل ریسکبندی و راهحلهای پیشنهادی

اجرای Pentest (با نگهداری حریم امن تست و خطمشی غیرتخریبی) و گزارش عملیاتی

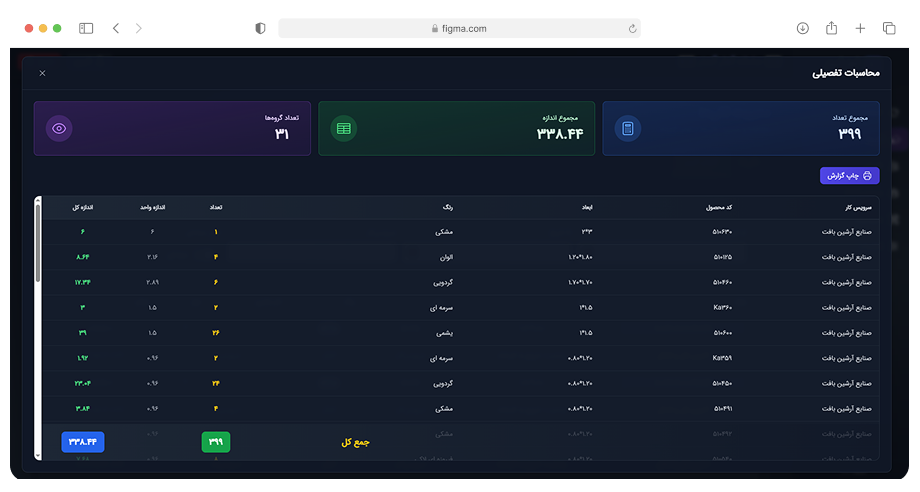

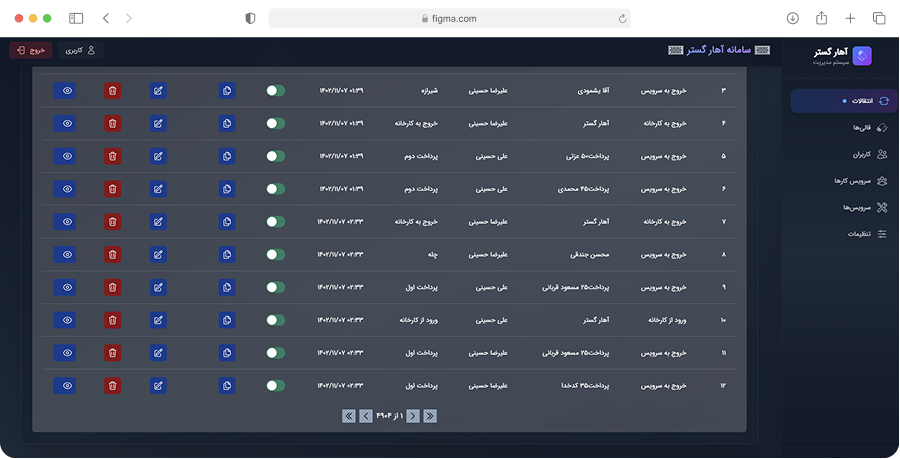

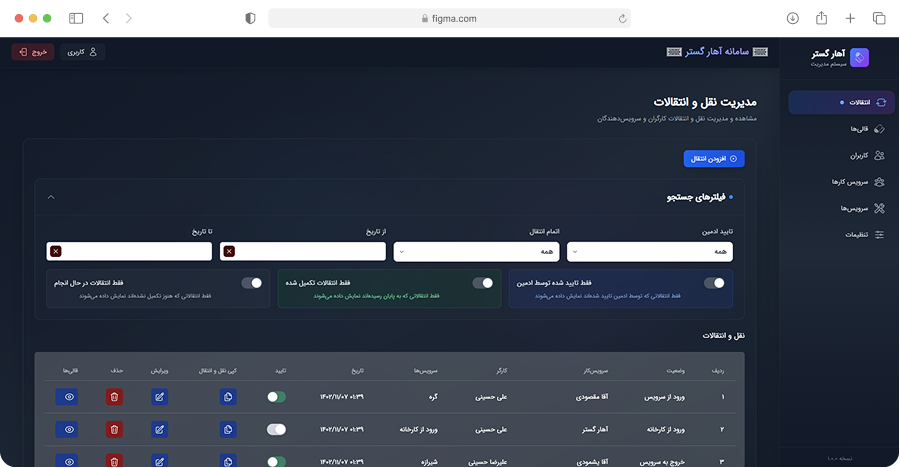

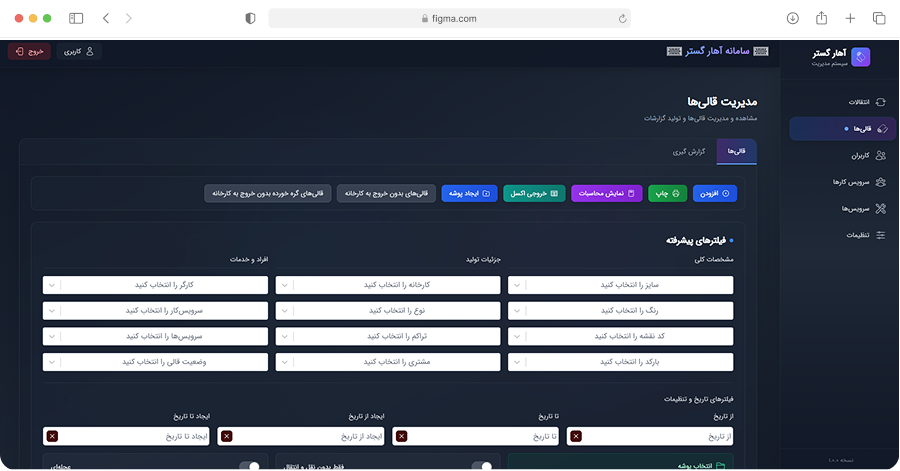

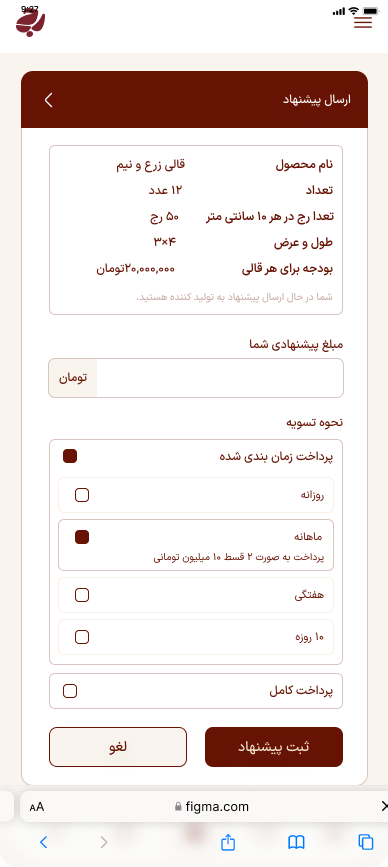

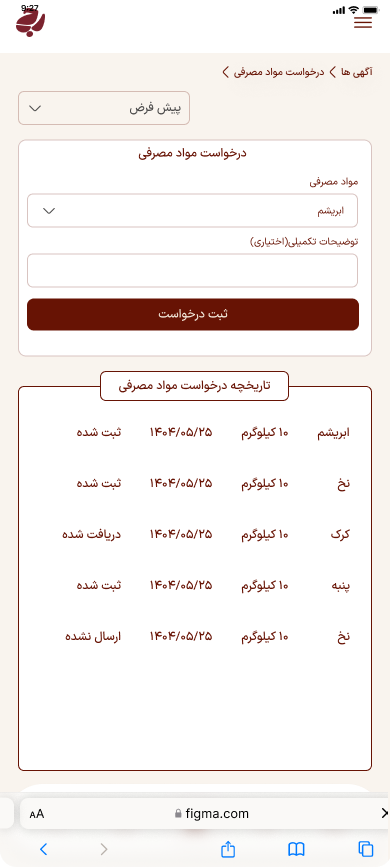

سامانه آهارگستر

سیستم مدیریتی فرش

دستیار مدیریتی تولید فرش دستبافت

پروژه رج

مدیریت نقل وانتقال کتاب

فانوس